En su nuevo libro Daniel Innerarity reflexiona sobre las posibles incidencias de la Inteligencia Artificial (IA) en el sistema democrático. Automatizar las decisiones en sociedades ... cada vez más complejas no es ninguna novedad y para eso se inventaron los protocolos de actuación. Sin embargo, ahora se podrían delegar decisiones en una herramienta con cierto grado de autonomía por su alta sofisticación. ¿Quién decide cuándo no hay nadie a los mandos? Eso es lo que nos plantea Innerarity en 'Una teoría crítica de la Inteligencia Artificial'.

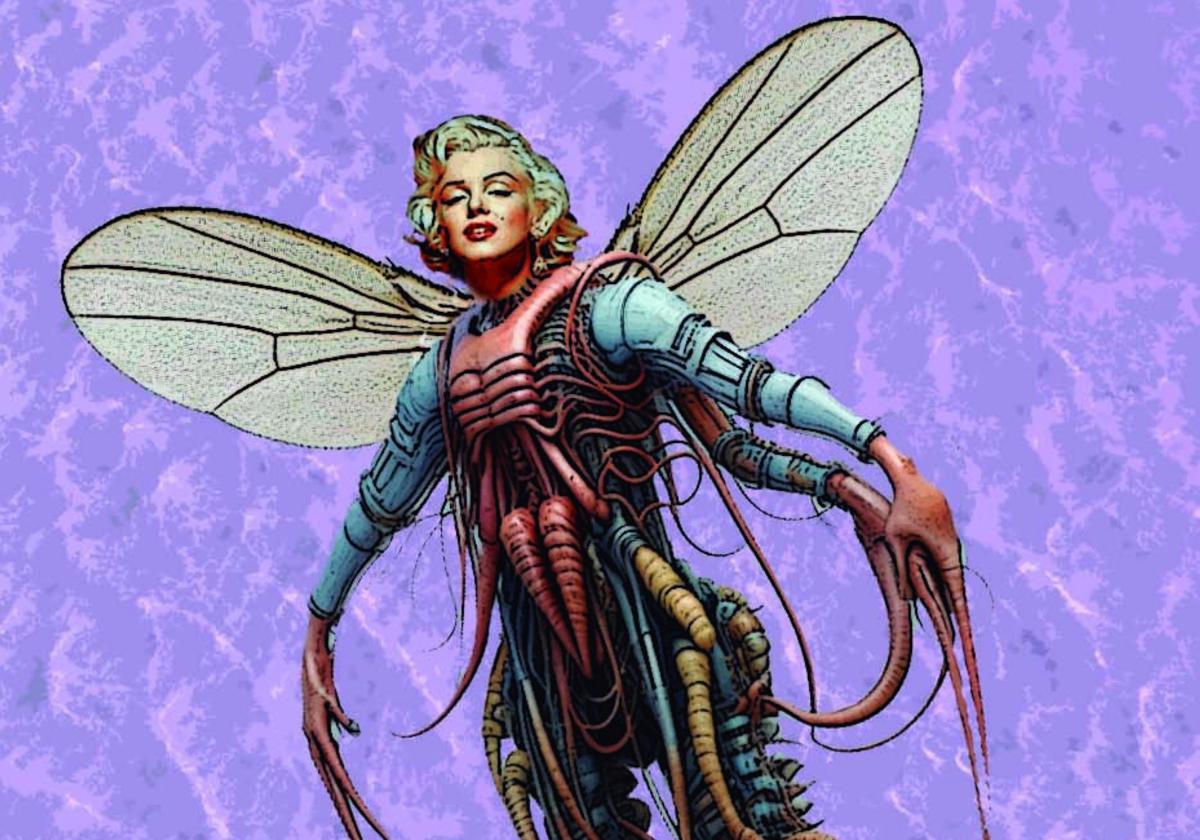

La ciencia-ficción cinematográfica no ha dejado de anticipar esta inquietud en películas como 'Alien' o '2001, una odisea en el espacio'. En las naves espaciales los ordenadores de a bordo se programan para cumplir con su misión sin que la tripulación lo supiera y con el mandato de sacrificar a las personas cuando perturbaran ese objetivo. Pero 'Hall 9000' no se programa solo y responde a las instrucciones que le han asignado. Siempre hay alguien que ha decidido. ¿Acaso podría la IA revisar de modo autónomo esas prescripciones en un futuro cercano?

Innerarity señala tres tipos de actuación para regular esa portentosa operatividad. Una moratoria no serviría de mucho, pues la regulación enseguida se vería desbordada y se podrían imponer unos intereses comerciales que decidieran continuar discretamente con su desarrollo. Las consideraciones éticas le parecen necesarias pero insuficientes. A su juicio deberían complementarse con una filosofía política de carácter crítico. Nada que objetar a ese lúcido análisis, aunque quizá sí quepa matizarlo. Por inútil que pudiera ser una moratoria, no estaría de más desacelerar un proceso demasiado vertiginoso, se requiere tiempo para reflexionar sobre hacia dónde queremos ir. '¿Por qué?' y '¿para qué?' son las cuestiones fundamentales de naturaleza ética, que deben preceder al '¿cómo?' y al '¿cuándo?'. Sin una brújula moral, difícilmente podremos fijar el rumbo de un viaje hacia una nueva era tecnológica que lo puede cambiar todo. Esta reflexión moral debe guiar su correspondiente filosofía política, sin supeditarse a las demandas del poder económico.

Los algoritmos deben facilitarnos el camino, pero no señalárnoslo como si no hubiera senderos alternativos

Vamos teniendo muestras de las turbulencias que pueden acarrear ciertos abusos o aplicaciones inapropiadas. Por una parte, las relaciones afectivas encuentran un asidero para no salir de la soledad, con ese simulacro que permite moldear a voluntad una pareja, familiar o amigo cibernéticos, hasta el punto de contraer matrimonio con sus hologramas predilectos. Al tiempo que se condena el autoplagio, vienen a darse por buenos los Plagios con mayúscula en las artes o las producciones académicas, y se valoran más que los originales en los que se han inspirado.

De sus aplicaciones en el campo militar sabemos muy poco, aunque cabe temer que aquí las consideraciones éticas quedarán excluidas por un presunto bien mayor y que la filosofía política tampoco se mostrará muy eficaz a la hora de poner bridas al asunto. En medicina se podrán refinar diagnósticos e innovar tratamientos, pero siempre bajo supervisión humana, por muy tentador que resulte abaratar costes para optimizar la ganancia de las inversiones.

En lo tocante a la desinformación, bulos e improperios, habría que tomar medidas para impedir su libre circulación por las redes, dada su alta toxicidad y el daño social que conllevan. La propaganda política está recurriendo a la IA para difundir vídeos amañados y el siguiente paso será tener que demostrar su inautenticidad a la vista de su extrema verosimilitud, en ocasiones mayor que la propia realidad.

El catálogo de incidencias en lo cotidiano y en cuestiones vitales de la esfera pública es interminable. Por eso urge tomarse muy en serio que preterir a la ética puede salirnos muy caro, por mucho que reporte pingües beneficios a quienes pretendan comercializar sin obstáculos la IA, o moleste a quienes pretendan utilizarla en beneficio propio. Hace falta una filosofía política presidida por la moral, con arreglo al modelo kantiano de 'político moral', para fijar los derroteros de una IA cuyas prestaciones no pueden ser cualesquiera, ni responder sin más a la lógica del beneficio y a las demandas de un consumo inapropiado.

Los algoritmos deben facilitarnos el camino, pero no señalárnoslo como si no hubiera senderos alternativos, porque de lo contrario estaríamos renunciando a nuestra responsabilidad al delegarla en ese itinerario algorítmico; e igualmente con ese proceder hipotecaríamos nuestra irrenunciable libertad para equivocarnos o acertar aprendiendo de nuestros errores, ya que afortunadamente nunca dejaremos de ser falibles y eso nos hace acordar con los demás las reglas de nuestra convivencia. No conviene poner el carro delante de los bueyes, porque así no vamos a ninguna parte.

Comentar es una ventaja exclusiva para suscriptores

¿Ya eres suscriptor?

Inicia sesiónNecesitas ser suscriptor para poder votar.